(报告出品方/作者:国信证券,马成龙、付晓钦)

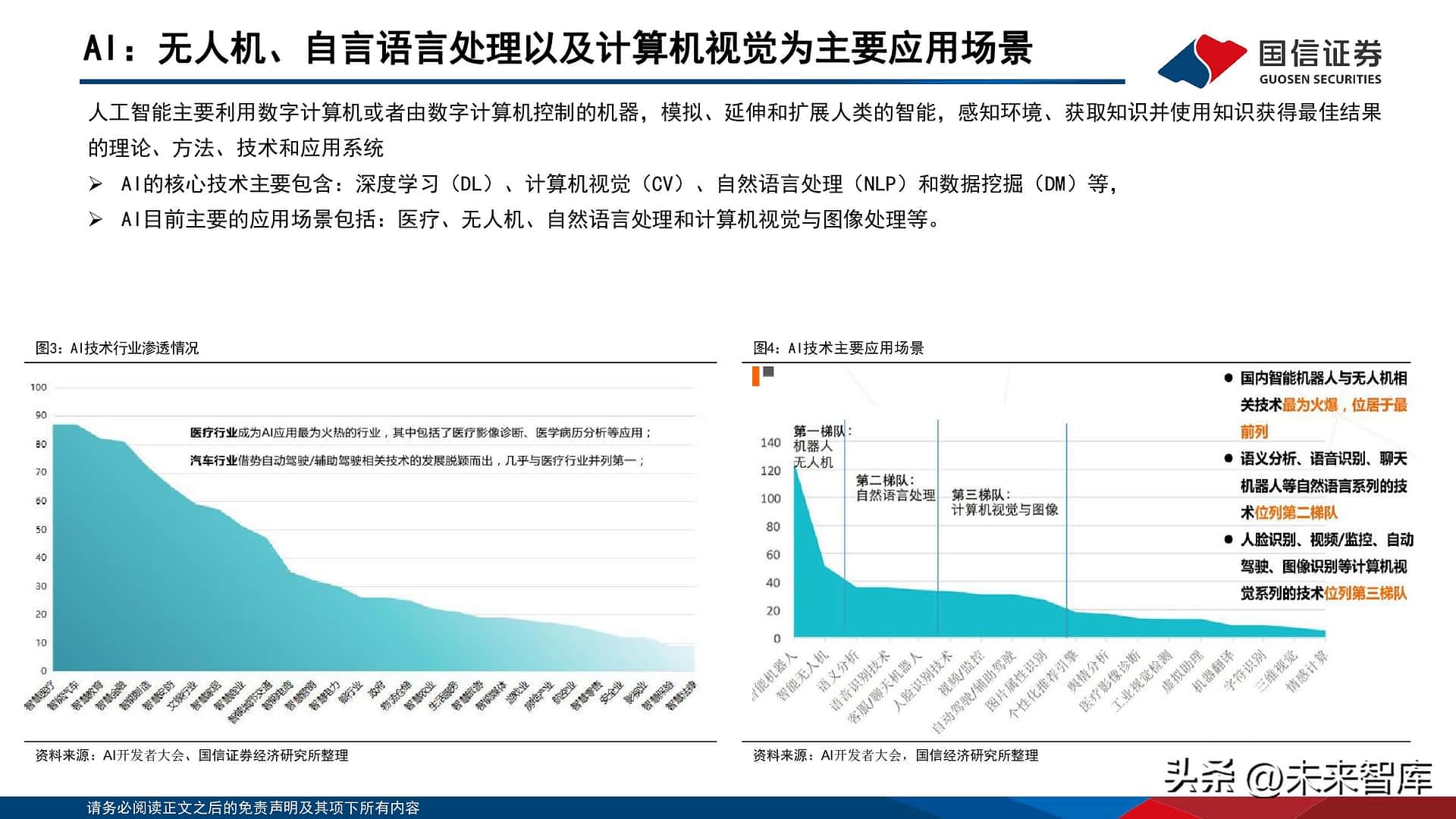

AI加速超算/智算中心发展趋势

AIGC等新场景:有望成为新一轮的云基建建设驱动力

AIGC等新应用场景的出现,成为未来云基建投资的重要推动力。数据中心作为流量的基石,算力的重要载体,核心受益於算力和流量的扩张,近十年行业经历了几轮快速的发展增长,分别受益於移动互联网、疫情带来的线上流量增长等;随着AI等新应用场景的出现,为行业赋予了新的增长动能,有望带动行业新一轮建设升级。

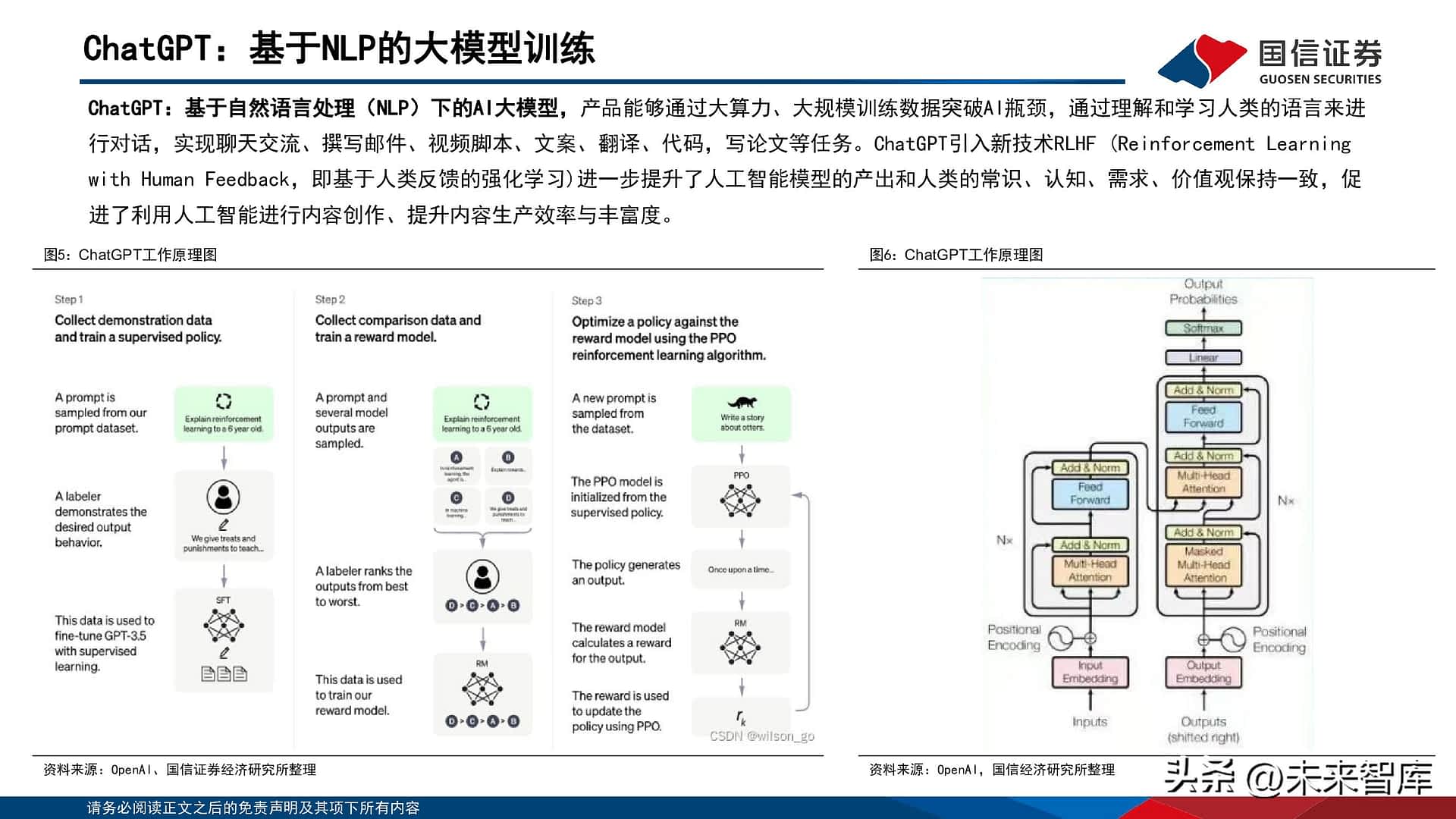

ChatGPT:基於NLP的大模型训练

ChatGPT:基於自然语言处理(NLP)下的AI大模型,产品能够通过大算力、大规模训练数据突破AI瓶颈,通过理解和学习人类的语言来进行对话,实现聊天交流、撰写邮件、视频脚本、文案、翻译、代码,写论文等任务。ChatGPT引入新技术RLHF (ReinforcementLearningwith Human Feedback,即基於人类反馈的强化学习)进一步提升了人工智慧模型的产出和人类的常识、认知、需求、价值观保持一致,促进了利用人工智慧进行内容创作、提升内容生产效率与丰富度。

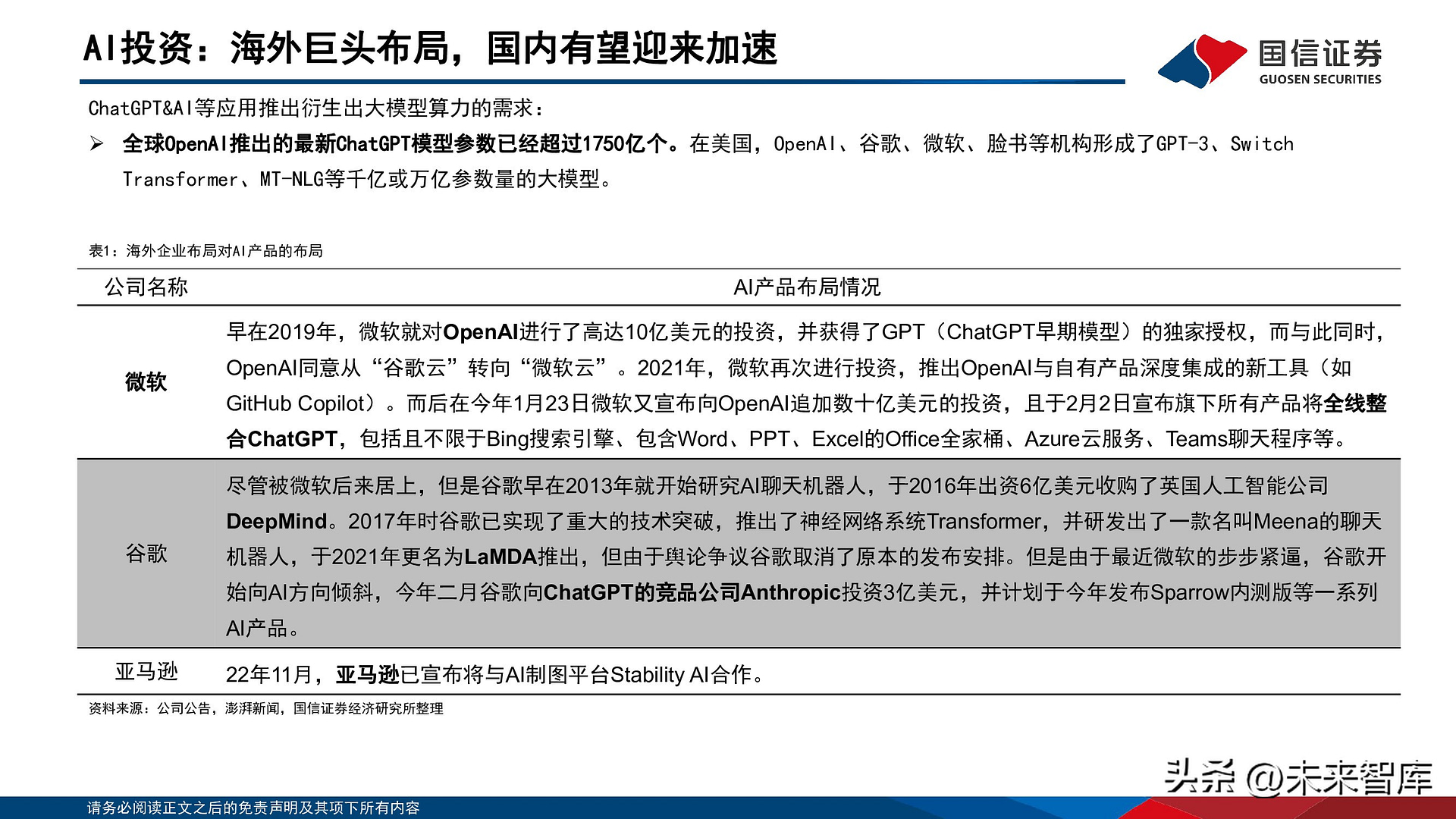

AI投资:海外巨头布局,国内有望迎来加速

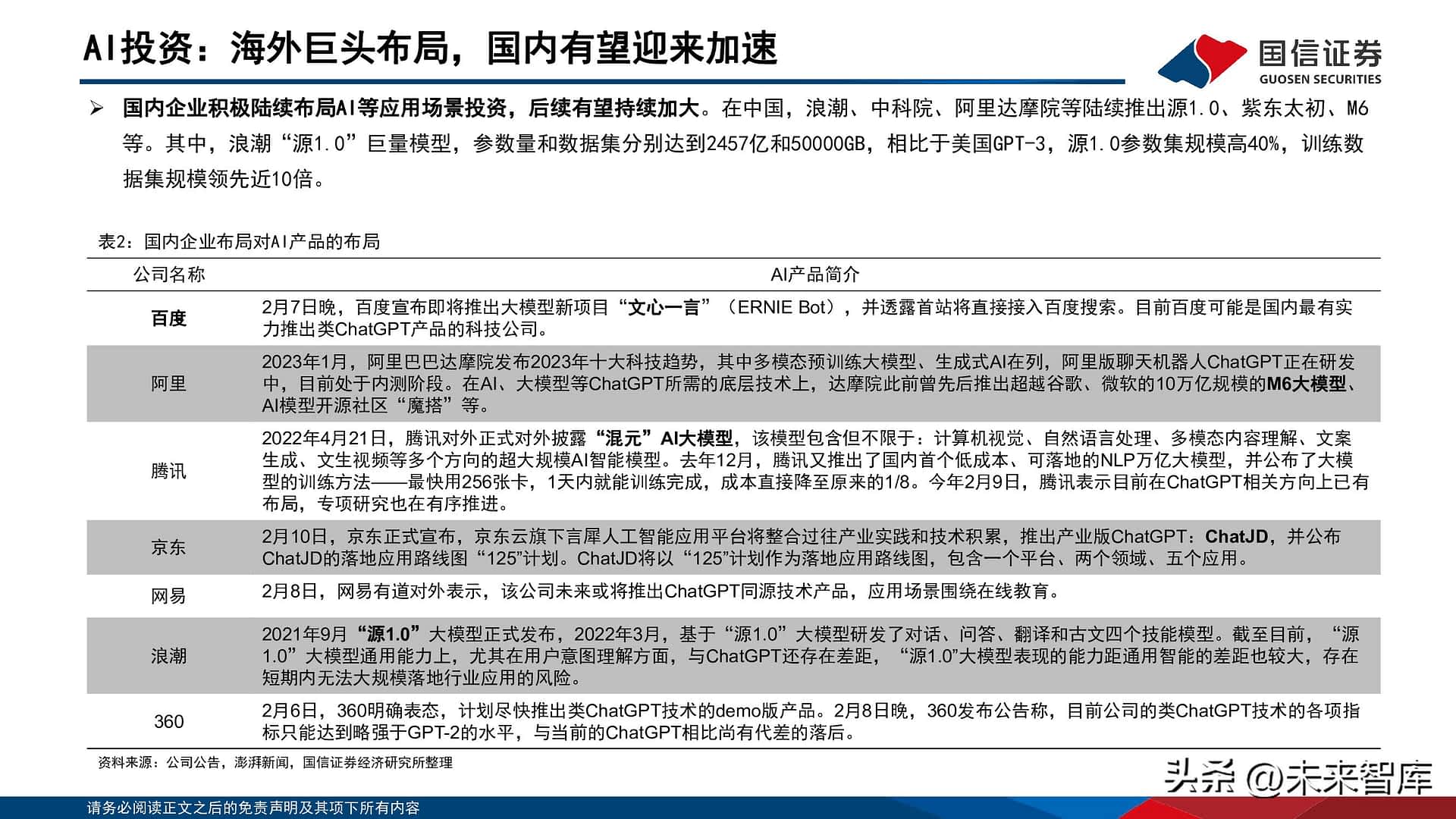

国内企业积极陆续布局AI等应用场景投资,後续有望持续加大。在中国,浪潮、中科院、阿里达摩院等陆续推出源1.0、紫东太初、M6等。其中,浪潮「源1.0」巨量模型,参数量和数据集分别达到2457亿和50000GB,相比於美国GPT-3,源1.0参数集规模高40%,训练数据集规模领先近10倍。

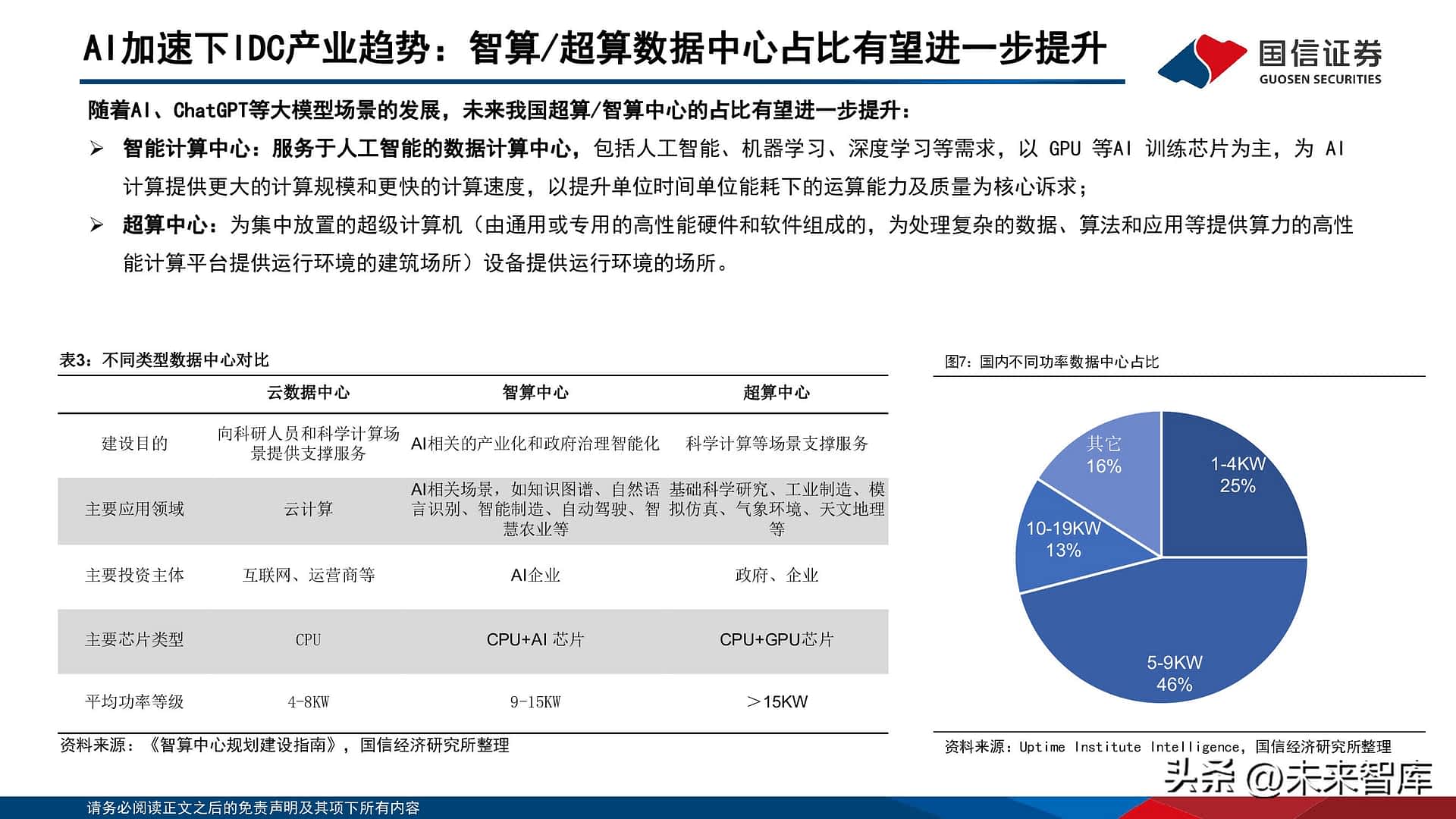

AI加速下IDC产业趋势:智算/超算数据中心占比有望进一步提升

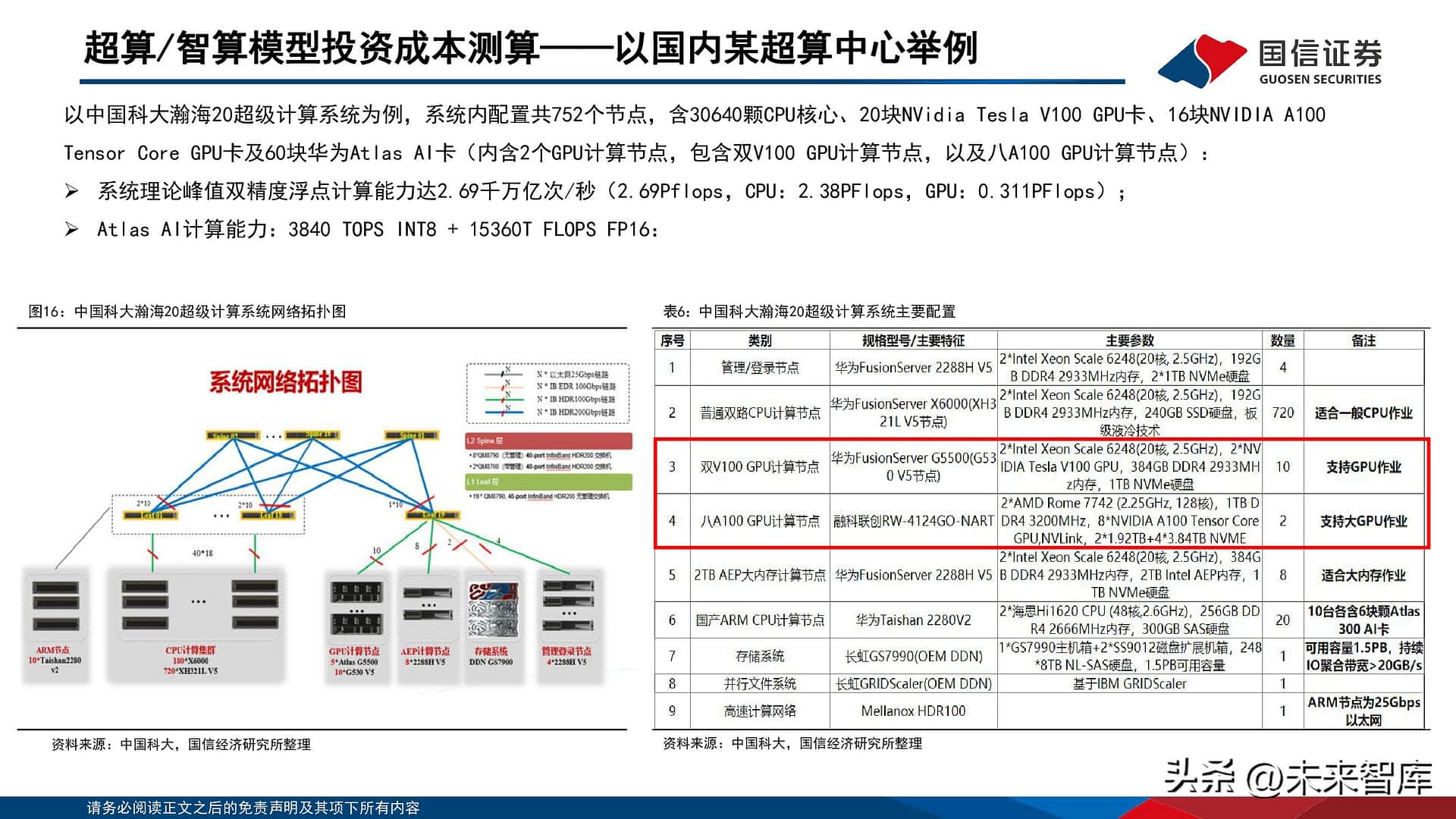

随着AI、ChatGPT等大模型场景的发展,未来我国超算/智算中心的占比有望进一步提升: 智能计算中心:服务於人工智慧的数据计算中心,包括人工智慧、机器学习、深度学习等需求,以 GPU 等AI 训练晶元为主,为AI计算提供更大的计算规模和更快的计算速度,以提升单位时间单位能耗下的运算能力及质量为核心诉求; 超算中心:为集中放置的超级计算机(由通用或专用的高性能硬体和软体组成的,为处理复杂的数据、演算法和应用等提供算力的高性能计算平台提供运行环境的建筑场所)设备提供运行环境的场所。

我国目前建成的智算中心超过20个,未来比例有望进一步提升

截至2021年底,我国在用数据中心机架总规模达 520 万标准机架,在用数据中心伺服器规模1900万台,算力总规模超过140 EFLOPS,其中在用超大型和大型数据中心超过 450个,智算中心超过20个,投资主体包括云厂商、AI企业、政府等,典型的数据中心案例包括; 阿里云张北超级智算中心可提供12EFLOPS(每秒1200亿亿次浮点运算)AI算力,将超过谷歌的9 EFLOPS和特斯拉的1.8 EFLOPS,成为全球最大的智算中心,可为AI大模型训练、自动驾驶、空间地理等人工智慧探索应用提供强大的智能算力服务;商汤「新一代人工智慧计算与赋能平台」临港超算中心总算力规模超过 3700PFLOPS。总投资金额超过 50 亿元人民币,一期将安置5000个等效8000W 的机柜。算力中心建成并投入使用後,可同时接入850万路视频,1天即可完成 23600 年时长的视频处理工作; 南京智算中心已运营AI计算能力达每秒80亿亿次(AI算力远超传统数据中心提供的基础算力供给),采用浪潮AI伺服器算力机组,搭载寒武纪思元270 和思元290智能晶元及加速卡。1 小时可完成100亿张图像识别、300万小时语音翻译或1万公里的自动驾驶AI 数据处理任务。

ChatGPT场景下智算中心投资趋势测算

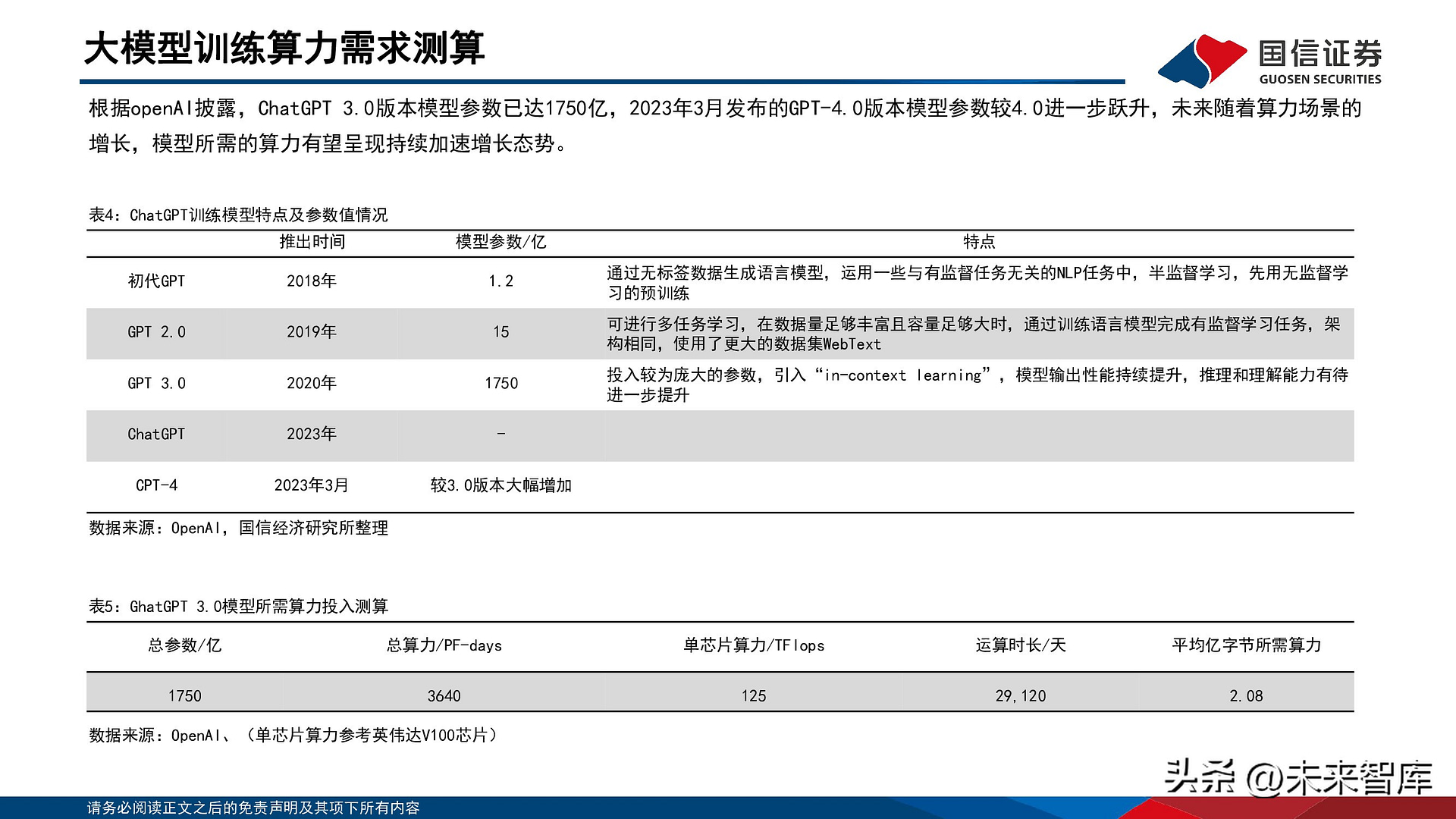

大模型训练算力需求测算

根据openAI披露,ChatGPT 3.0版本模型参数已达1750亿,2023年3月发布的GPT-4.0版本模型参数较4.0进一步跃升,未来随着算力场景的增长,模型所需的算力有望呈现持续加速增长态势。

超算/智算模型投资成本测算——单台GPU及配套

未来大模型的参数训练主要通过GPU完成,以NVIDIA DGX A100 基础架构通用系统举例,单台GPU配置包括: 从算力上看:产品配置8个英伟达A100GPU,320GHNM2 GPU存储、6个第二代NV Switch、2块64核AMD CPU、2TB内存,并针对NVIDIACUDA-X? 软体和整套端到端 NVIDIA 数据中心解决方案进行全面优化。同时,产品提供高速网路连接选项,进一步提高可扩展性提升响应速度,系统配置NVIDIA? ConnectX?-7 InfiniBand 或乙太网网卡,双向带宽峰值为 500 GB/s。

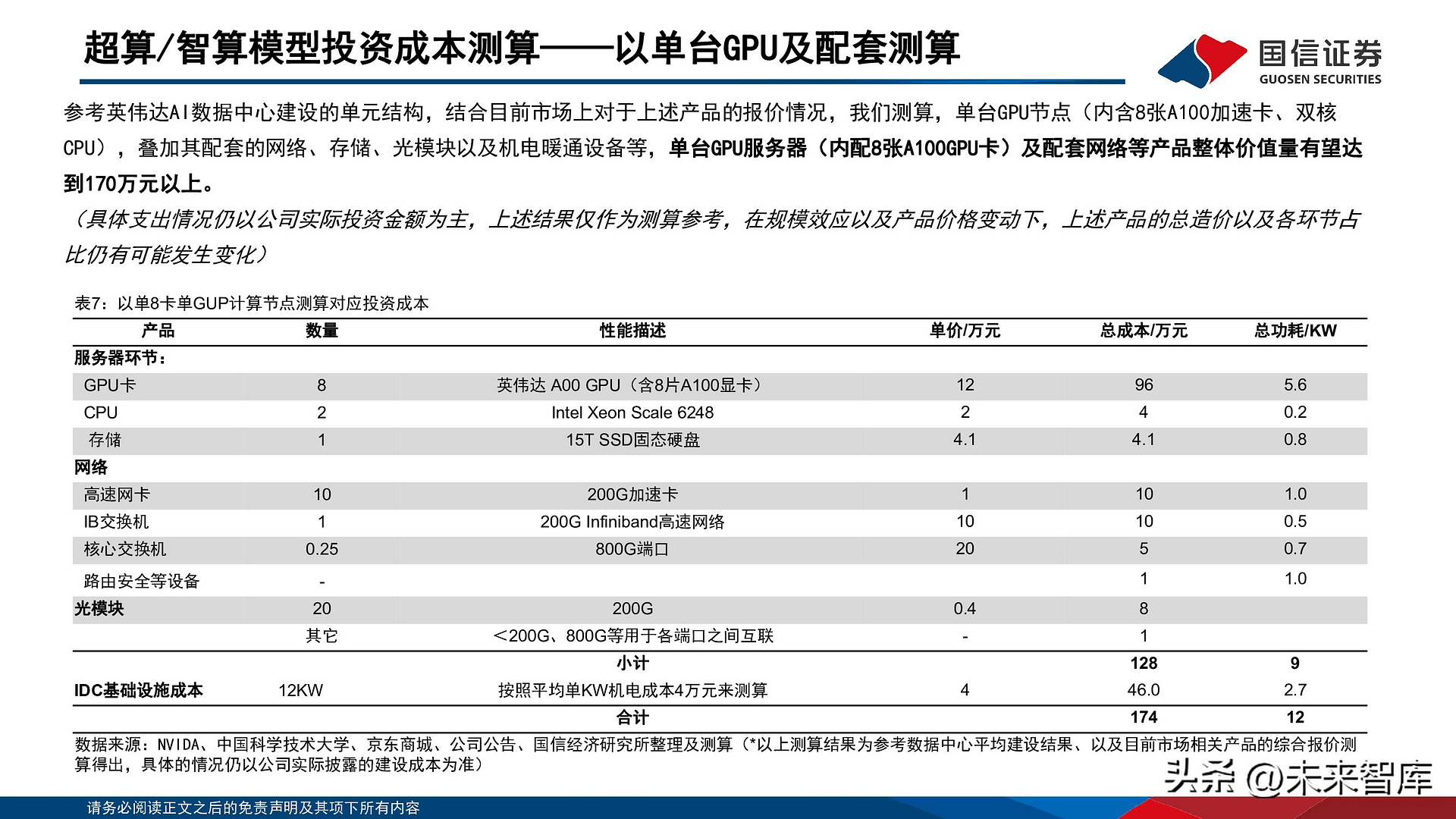

超算/智算模型投资成本测算——以单台GPU及配套测算

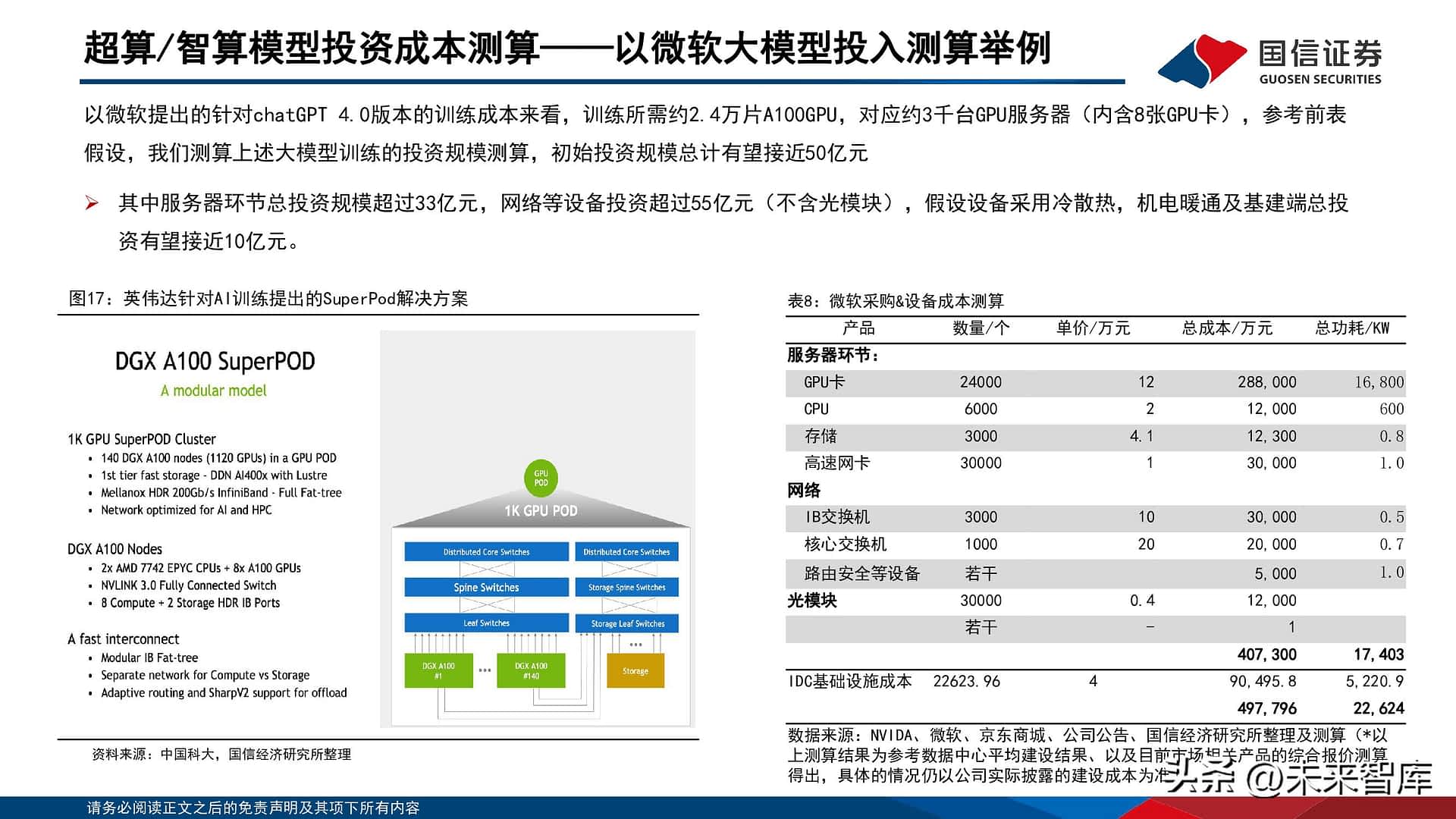

参考英伟达AI数据中心建设的单元结构,结合目前市场上对於上述产品的报价情况,我们测算,单台GPU节点(内含8张A100加速卡、双核CPU),叠加其配套的网路、存储、光模块以及机电暖通设备等,单台GPU伺服器(内配8张A100GPU卡)及配套网路等产品整体价值量有望达到170万元以上。

投资成本对比分析:传统数据中心VS超算/智算数据中心

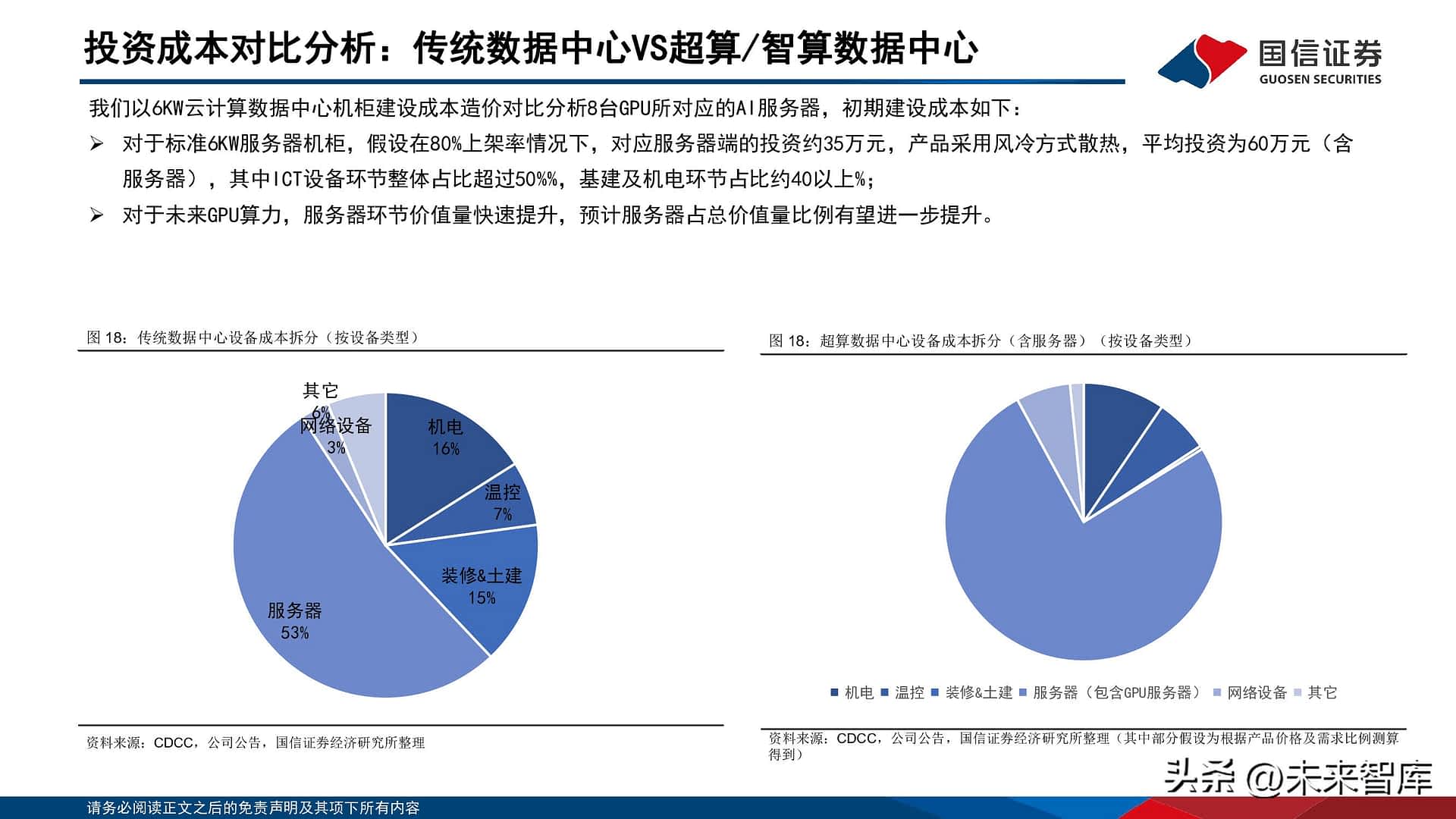

我们以6KW云计算数据中心机柜建设成本造价对比分析8台GPU所对应的AI伺服器,初期建设成本如下: 对於标准6KW伺服器机柜,假设在80%上架率情况下,对应伺服器端的投资约35万元,产品采用风冷方式散热,平均投资为60万元(含伺服器),其中ICT设备环节整体占比超过50%%,基建及机电环节占比约40以上%; 对於未来GPU算力,伺服器环节价值量快速提升,预计伺服器占总价值量比例有望进一步提升。

高密算力下ICT及机电设备发展趋势

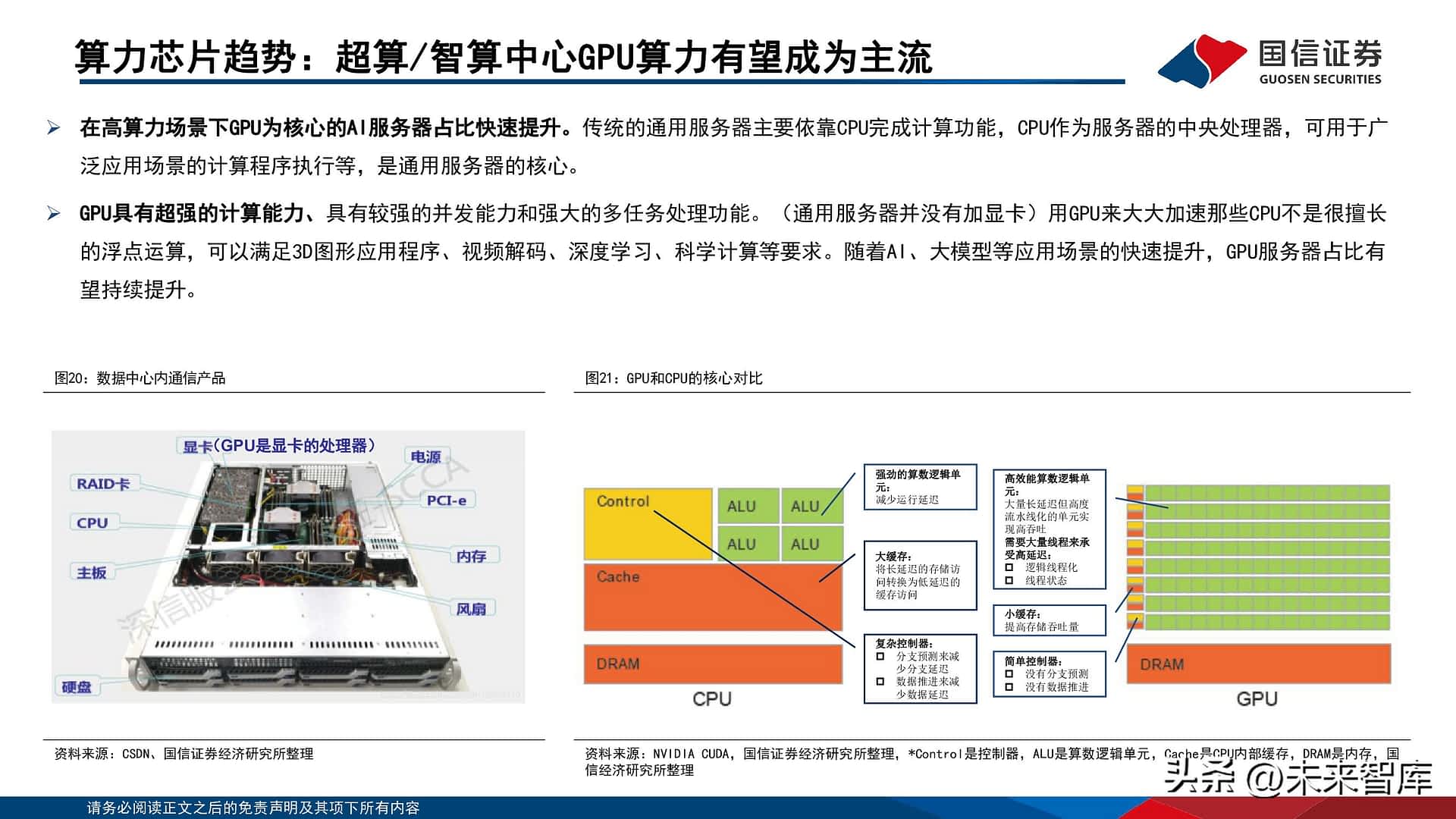

算力晶元趋势:超算/智算中心GPU算力有望成为主流

在高算力场景下GPU为核心的AI伺服器占比快速提升。传统的通用伺服器主要依靠CPU完成计算功能,CPU作为伺服器的中央处理器,可用於广泛应用场景的计算程序执行等,是通用伺服器的核心。 GPU具有超强的计算能力、具有较强的并发能力和强大的多任务处理功能。(通用伺服器并没有加显卡)用GPU来大大加速那些CPU不是很擅长的浮点运算,可以满足3D图形应用程序、视频解码、深度学习、科学计算等要求。随着AI、大模型等应用场景的快速提升,GPU伺服器占比有望持续提升。

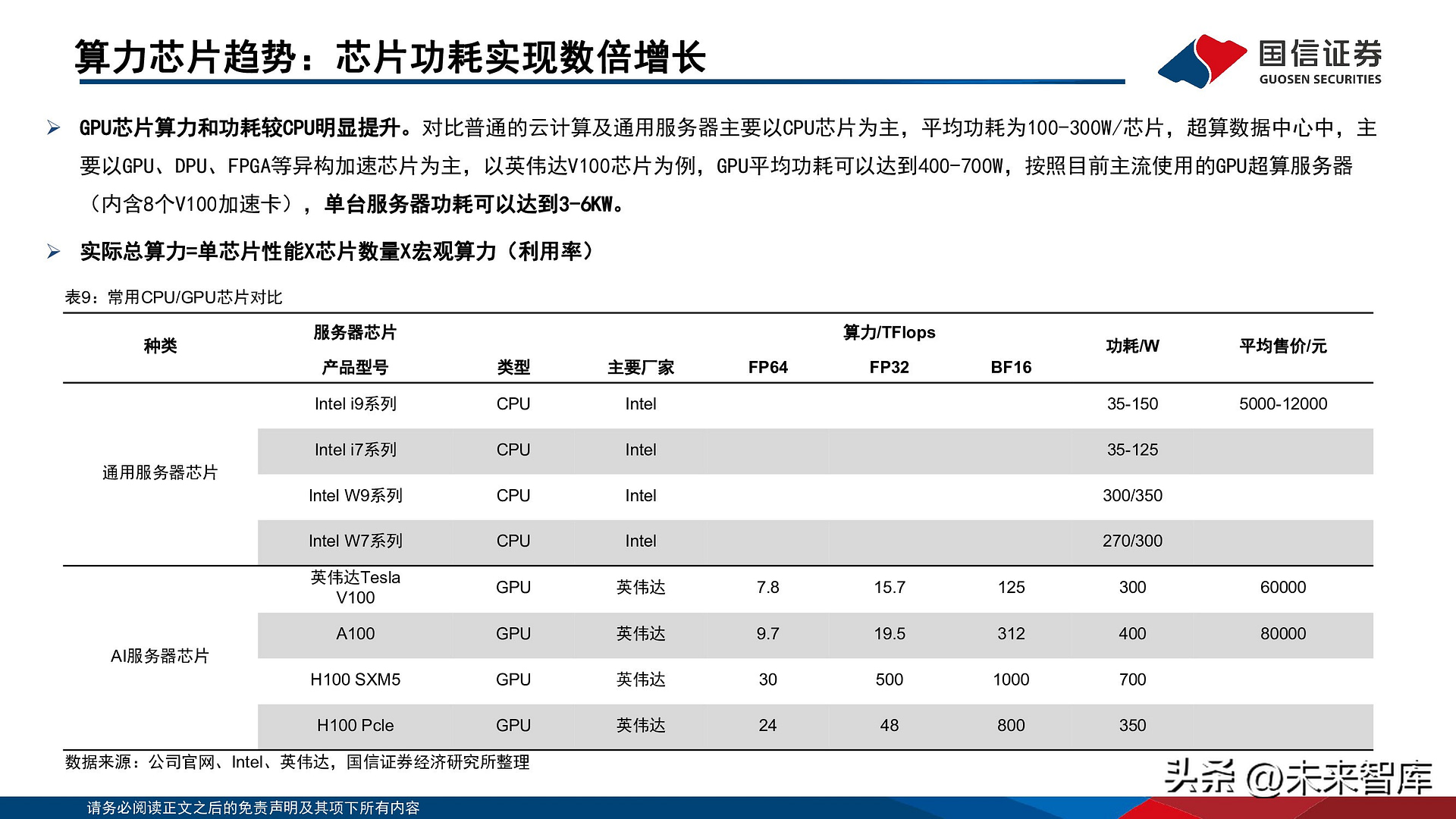

算力晶元趋势:晶元功耗实现数倍增长

GPU晶元算力和功耗较CPU明显提升。对比普通的云计算及通用伺服器主要以CPU晶元为主,平均功耗为100-300W/晶元,超算数据中心中,主要以GPU、DPU、FPGA等异构加速晶元为主,以英伟达V100晶元为例,GPU平均功耗可以达到400-700W,按照目前主流使用的GPU超算伺服器(内含8个V100加速卡),单台伺服器功耗可以达到3-6KW。 实际总算力=单晶元性能X晶元数量X宏观算力(利用率)。

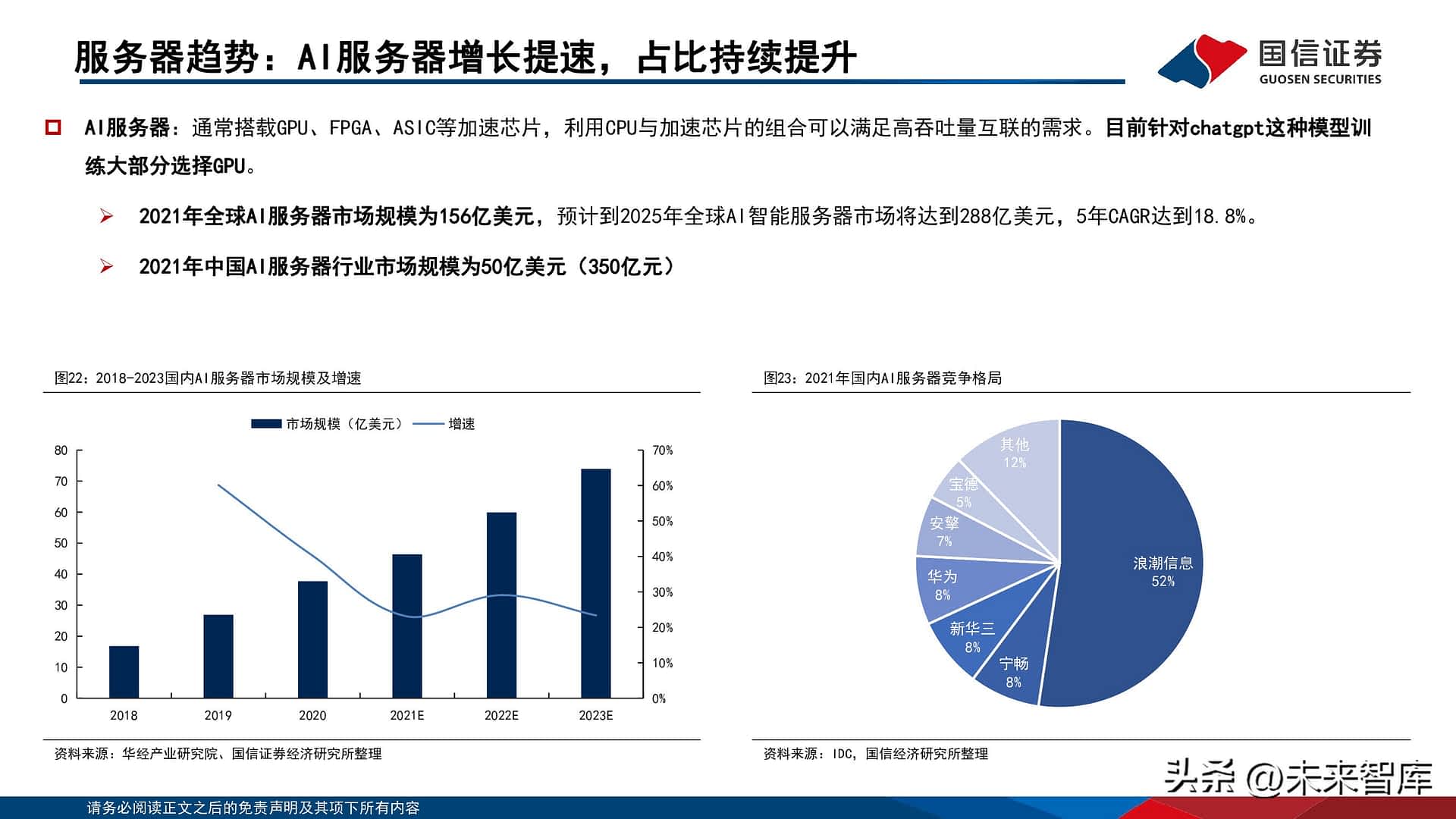

伺服器趋势:AI伺服器增长提速,占比持续提升

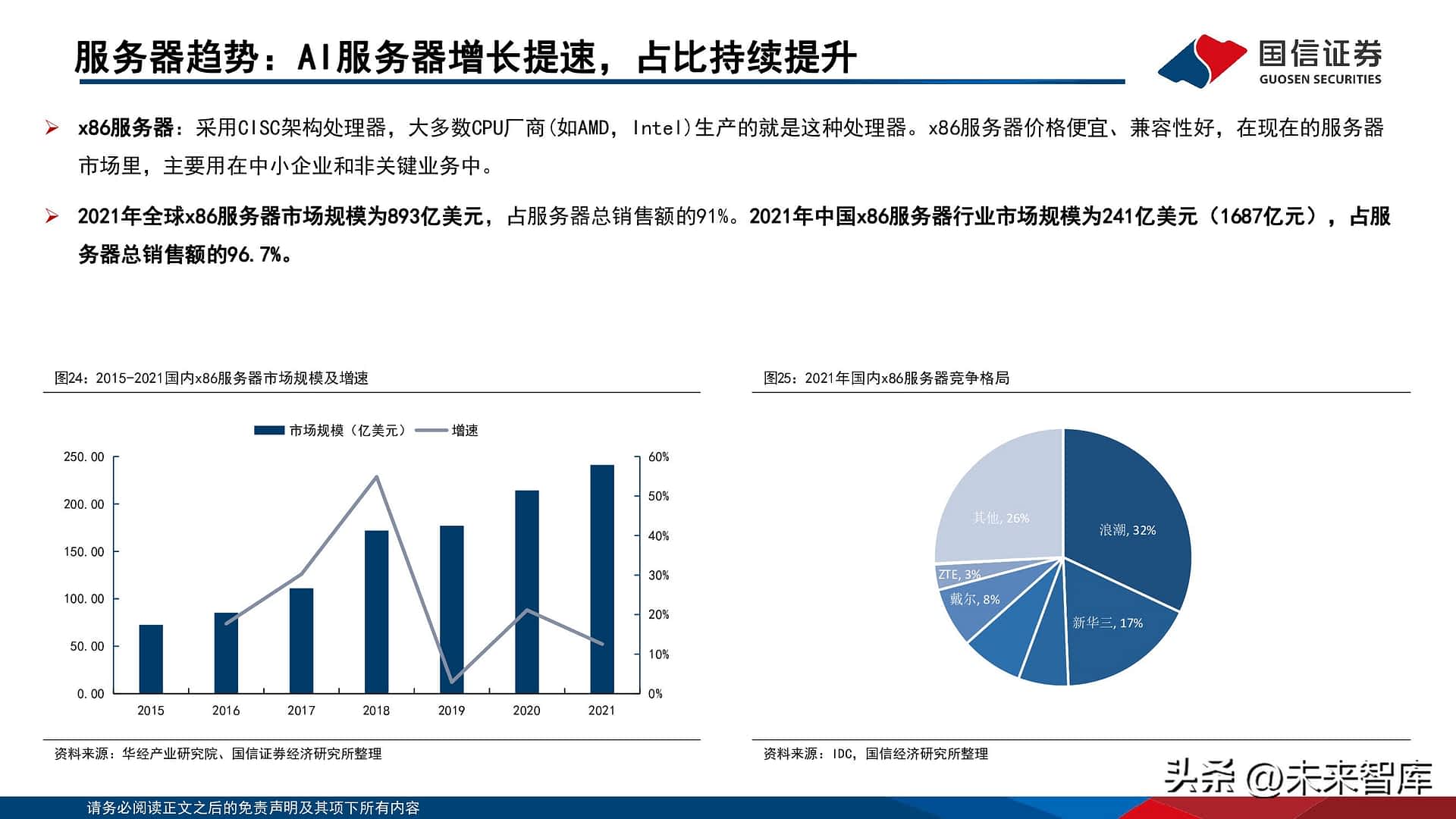

x86伺服器:采用CISC架构处理器,大多数CPU厂商(如AMD,Intel)生产的就是这种处理器。x86伺服器价格便宜、兼容性好,在现在的伺服器市场里,主要用在中小企业和非关键业务中。 2021年全球x86伺服器市场规模为893亿美元,占伺服器总销售额的91%。2021年中国x86伺服器行业市场规模为241亿美元(1687亿元),占伺服器总销售额的96.7%。

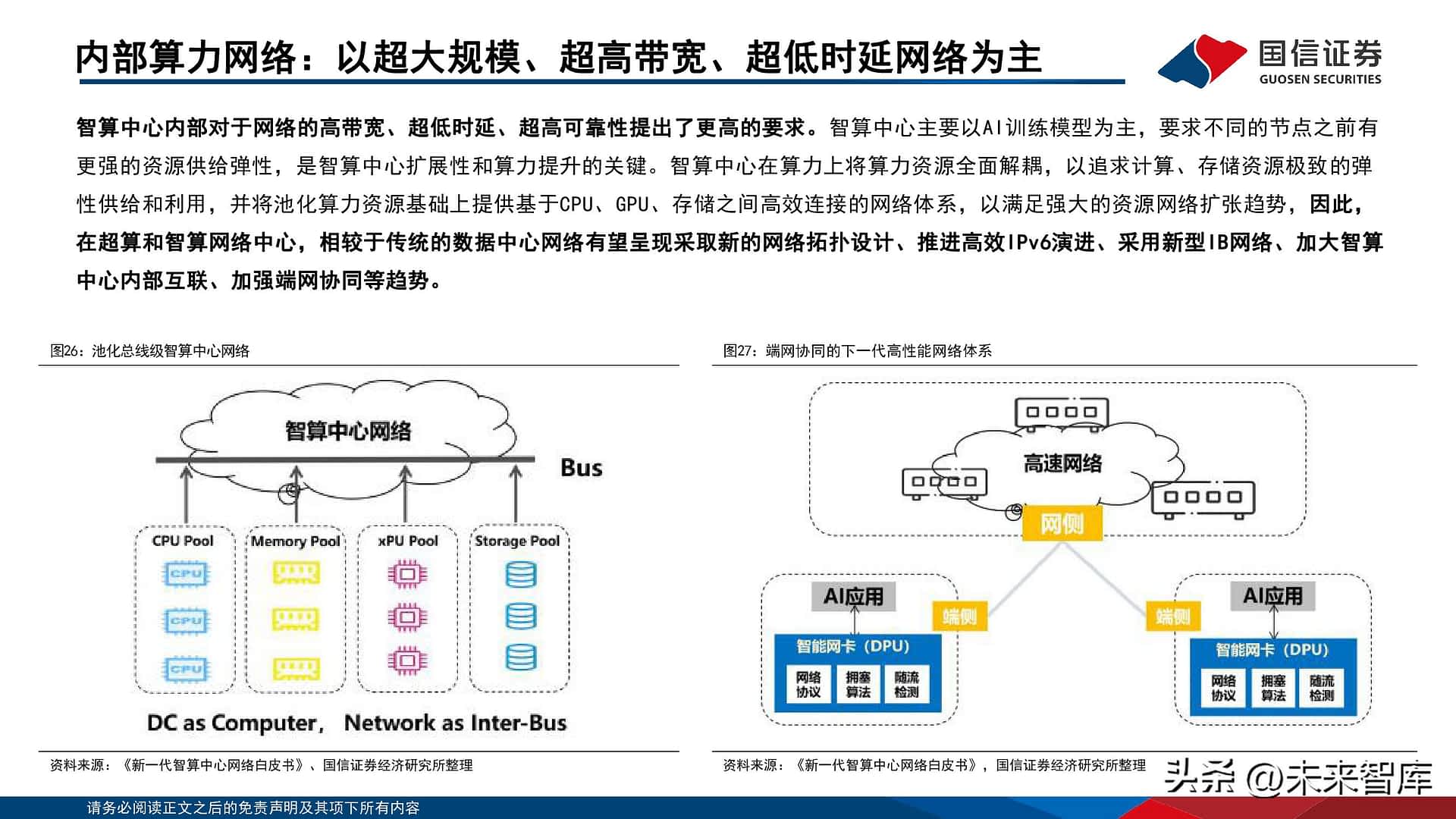

内部算力网路:以超大规模、超高带宽、超低时延网路为主

智算中心内部对於网路的高带宽、超低时延、超高可靠性提出了更高的要求。智算中心主要以AI训练模型为主,要求不同的节点之前有更强的资源供给弹性,是智算中心扩展性和算力提升的关键。智算中心在算力上将算力资源全面解耦,以追求计算、存储资源极致的弹性供给和利用,并将池化算力资源基础上提供基於CPU、GPU、存储之间高效连接的网路体系,以满足强大的资源网路扩张趋势,因此,在超算和智算网路中心,相较於传统的数据中心网路有望呈现采取新的网路拓扑设计、推进高效IPv6演进、采用新型IB网路、加大智算中心内部互联、加强端网协同等趋势。

高速算力网路:Infiniband高速网路

Infiniband网路(IB网路):是指通过一套中心 Infiniband 交换机在存储、网路以及伺服器等设备之间建立一个单一的连接链路,通过中心 Infiniband 交换机来控制流量,能够降低硬体设备间数据流量拥塞,有效解决传统 I/O结构的通信传输瓶颈,还能与远程存储设备和网路设备相连接,是高算力网路主流架构;

光模块趋势:CPO(光电共封装)技术演变趋势

随着电口速率提升到112G,高速信号在PCB传输中的损耗随之增加,对PCB的设计难度、材料成本带来挑战,同时还需要在可插拔光模块和交换晶元之间的高速走线上增加更多的Retimer晶元,整机的运行功耗也将大幅提升。为了克服这些问题,CPO逐渐成为共识。CPO也就是将光模块不断向交换晶元靠近,缩短晶元和模块之间的走线距离,并逐步替代可插拔光模块,最终把交换晶元(或XPU)ASIC和光/电引擎(光收发器)共同封装在同一基板上,引擎尽量靠近ASIC,以最大程度地减少高速电通道损耗和阻抗不连续性,从而可以使用速度更快、功耗更低的片外I/O驱动器。 目前CPO还有许多亟待解决的关键技术问题需要突破,例如如何选择光引擎的调制方案、如何进行架构光引擎内部器件间的封装以及如何实现量产可行的高耦合效率光源耦合。传统的基於像EML、DML 等分立式光学引擎设计的一些方式,基本上不再能满足Co-packaging 对空间的一些要求。 目前主流的CPO有两种技术方案和应用场景。一是基於VCSEL 的多模方案,30m 及以下距离,主要面向超算及AI集群的短距光互联;二是基於硅光集成的单模方案,2 公里及以下距离,主要面向大型数据中心内部光互联。硅基方案具有无需气密封装、高带宽、易集成等优势。

温控设备趋势:液冷的价值量占比较风冷有望明显提升

以单KW价值量来算,液冷环节的价值量较传统的风冷冷却方式有望较快增长。根据CDCC 2020年披露,液冷机组环节在数据中心建造成本中占比约15%-17%,考虑到传统风冷技术相对成熟,液冷涉及到伺服器机组内部(冷板)、管道接头、外部冷冻水机、水泵、冷却液等诸多环节,从全链条价值量看,液冷系统的价值量在数据中心建造成本构成(不含伺服器)中占比有望进一步提升。市场竞争相对充分,我们认为,从风冷—间接蒸发冷—液冷的升级的过程中,液冷在数据中心单KW建造成本中价值量有望持续提升(高功率有望接近20%)。

IDC行业周期趋势回顾

政策端:基础设施仍然是未来投资重要的方向

AIGC等新应用场景的出现,成为未来云基建投资的重要推动力。数据中心作为流量的基石,算力的重要载体,核心受益於算力和流量的扩张,近十年行业经历了几轮快速的发展增长,分别受益於移动互联网、疫情带来的线上流量增长等;随着AI等新应用场景的出现,为行业赋予了新的增长动能,有望带动行业新一轮建设升级。

新场景带来的流量扩张,推动行业需求快速增长

移动互联网流量爆发式增长,是推动IDC行业发展的第一波浪潮。移动互联网的流量快速发展的周期始於2013年,随着行动电话的普及、移动网路升级流量迎来快速增长。2018年,在各种线上线下服务加快融合,移动互联网业务创新大力驱动下,移动支付/出行/视频直播等应用场景快速普及,移动互联网接入流量增速创下新高(同比 189%)。 2020年,随着疫情的爆发,大量的线下场景转为线上,带动了行业第二波高速增长。参考我国第三方IDC企业龙头万国数据、世纪互联,二者均在2013-2015年间、2018-2020年享受了行业高增长带来的增长红利。

机柜数:存量机构数超过350万架

数据中心是算力重要载体,2021年我国存量机柜数超过350万架。根据CDCC统计,截至2021年,我国存量数据中心机柜数超过350万架,其中华东地区超过100万架,华南华北地区分别达到90/80万架,未来随着数字经济发展以及流量的增长,国内数据中心2025年规模有望超过750万架。 行业内平均上架率约58%。根据科智谘询统计,截止当前我国IDC机柜平均上架率约58%,在保持基础设施建设适当超前水平下,预计未来行业上架率整体有望维持在该水平区间。

第三方IDC:22年交付情况各异,需求复苏下景气度提升

修正後预计22年新增机柜数较此前略有下调,主要受到了疫情及客户上架速度影响。根据各家公告数统计,国内头部第三方IDC企业2021年交付总机柜数超过49万架,较2020年全年新交付14万架,2021年全年交付机柜数达到历史较高水平,我们於2022年年初预期上述头部第三方IDC企业自建的机柜数较2021年预期新增约12万架,22年全年受到疫情对於交付节奏以及客户商家需求的变化,实际新增加机柜数出现一定下滑,调整後预期2022年头部新交付机柜数约10万架(因22年年初未给予润泽科技预测,上述口径并未考虑润泽科技)。现预期,头部第三方IDC企业2023年新增机柜数约15万架(考虑润泽科技),各企业对於23年的战略将主要以客户需求结合实际情况确定具体的项目交付情况,主要以提升存量机柜的上架率兼顾中远期客户发展需求,同时加大海外市场的开拓进度。

报告节选:

(本文仅供参考,不代表我们的任何投资建议。如需使用相关信息,请参阅报告原文。)

精选报告来源:【未来智库】。500 Internal Server Error

喜欢这篇文章吗?立刻分享出去让更多人知道吧!

本站内容充实丰富,博大精深,小编精选每日热门资讯,随时更新,点击「抢先收到最新资讯」浏览吧!

请您继续阅读更多来自 未来智库 的精彩文章:

※光器件行业深度研究:从通信基石到智能之眼

※建筑行业专题报告:「一带一路」十周年,龙头蓄力再向前